本地部署视频AI模型之"StreamingT2V"

探索Picsart AI Research团队发布的StreamingT2V模型,这是一种先进的自回归技术,能够从文本生成长达2分钟的高质量视频。StreamingT2V不仅能够生成比以往模型更长的视频,还能与SVD、animatediff等其他主流模型无缝衔接,且完全开源,为视频生成领域带来了新的突破。了解如何本地部署这一创新的AI模型,并探索其在创造动态一致视频内容方面的能力。

今天分享一个由Picsart AI Research团队联合发布的StreamingT2V模型,本地部署搭建的过程,可生成长达2分钟(1200帧)的高质量视频,目前已经超越了之前的Sora模型,这一开源模型不仅可以生成更长时长的视频,还能与SVD、animatediff等其他模型无缝兼容,为开源视频生成领域带来新的突破。该模型的突出亮点:

- 生成时长达2分钟(1200帧),超越以往模型

- 视频质量高

- 与业内其他主流模型可以实现无缝衔接

- 开源免费,便于开发者使用和二次开发

可生成视频的模型很多很多,下面效果使用的都是最简单的”文生视频“功能,首先分享一下该模型"文字生成视频"的效果:

一只在街头奔跑的小猫咪

,时长00:03一只在街头跳舞的龙猫

,时长00:03一对在街头拥抱的恋人

,时长00:03

现在正式分享搭建的过程,硬件要求有一张NIVDIA显卡(官方推荐的入门级是A100-80G,这个玩意太贵,没有大金主支撑玩不起,需要安装Git、Python与Cuda以及conda,这些基本环境安装简单不赘述。

- 克隆该项目到本地

cd StreamingT2V/

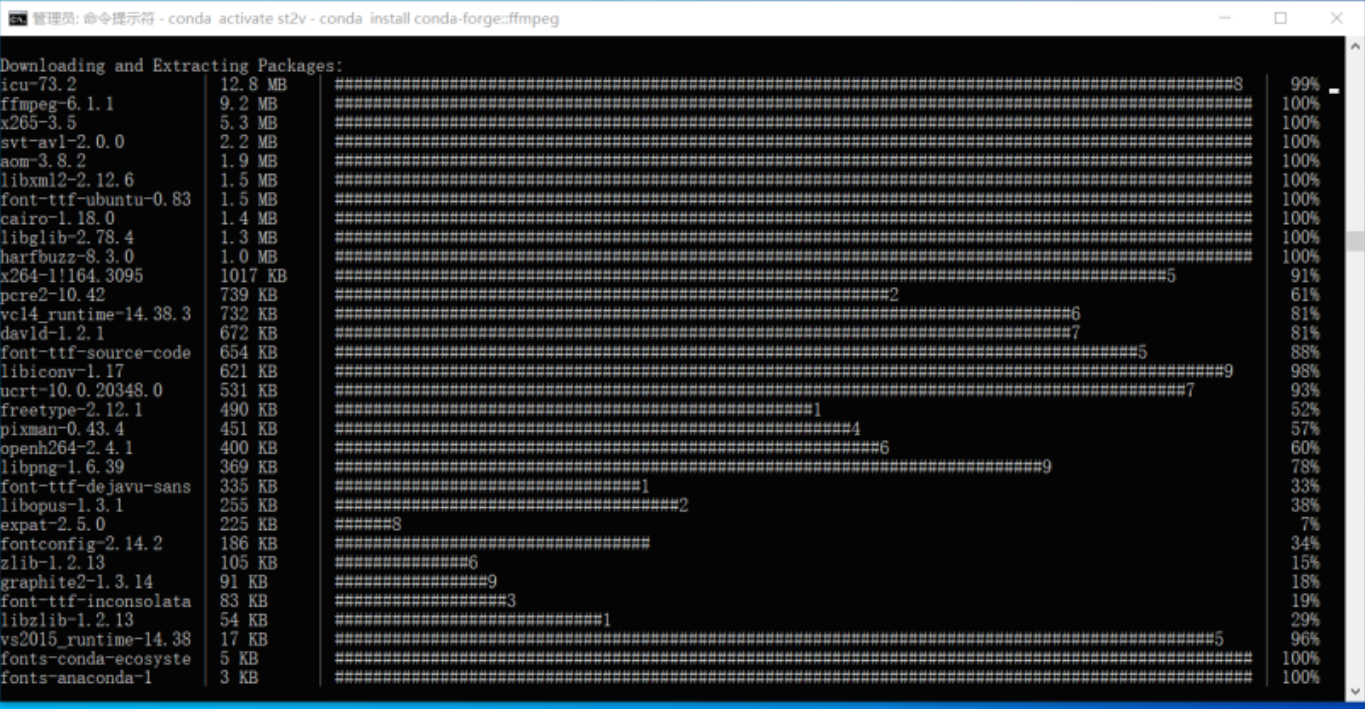

2.安装必备环境

conda create -n st2v python=3.10 && conda activate st2v

pip install -r requirements.txt

然后从官网下载模型权重包放在安装好的文件夹即可,这样就可以可是生成视频了,比较悲剧的是我的显卡是Nvidia T1000 4G,显卡太烂,生成视频的最后一步报错,有些功能不支持。

输入:python inference.py --prompt="A cat running on the street"

输入文字"一只在街头奔跑的小猫咪"以后,利用该描述文字,模型就开始生成相应视频,生成过程中电脑温度升高,读写频繁,并且需要联网(You Known)

生成视频的最后一步报错,CUDA编译某些模块错误,查了下我的显卡太烂不支持,手头宽裕的有A100显卡的小伙伴可以一试!